728x90

이미지 분류 신경망

AlexNet

- 영상 데이터베이스를 기반으로 한 화상 인식 대회 "ILSVRC 2012"에서 우승한 CNN 구조

- AlexNet은 합성곱층 다섯 개와 완전연결층 세 개로 구성되어 있으며, 맨 마지막 완전 연결층은 카테고리 1000개를 분류하기 위해 소프트맥스 활성화 함수를 사용

- LeNet5와 크게 다르지 않지만 GPU 두 개를 기반으로 한 병렬 구조인 점이 가장 큰 차이점

- AlexNet의 차별점

- ReLU의 사용

- 이전까지는 tanh 함수를 사용

- tanh에 비해 6배 빠른 속도

- overlapping pooling

- 풀링 커널이 움직이는 보폭인 stride를 커널 사이즈보다 작게 하는 방법

- Local Response Normalization(LRN)

- ReLU를 사용하여 양수값을 그대로 전달하면 너무 큰 값이 전달되어 주변의 다른 값에 비해 지나치게 강한 자극이 됨

- 따라서 일부 큰 값이 주변의 작은 값을 억누르는 효과를 방지

- 현재는 이 기법이 더 발전하여 Batch Normalization이 됨

- ReLU의 사용

- 모델 과적합을 막기 위한 방법

- dropout 사용

- Data augmentation 사용

- 데이터의 양을 늘리는 것

- 하나의 이미지를 가지고 여러 장의 비슷한 이미지를 만들어냄

VGGNet

- 카렌 시모니안(Karen Simonyan)과 앤드류 지서만(Andrew Zisserman)이 2015 ICLR에 게재한 Very deep convolutional networks for largescale image recognition 논문에서 처음 발표

- VGGNet은 합성곱층의 파라미터 수를 줄이고 훈련 시간을 개선하려고 탄생

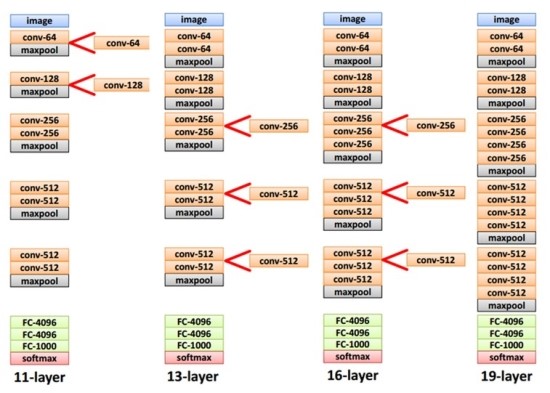

- 즉, 네트워크를 깊게 만드는 것이 성능에 어떤 영향을 미치는지 확인하고자 연구

- 깊이의 영향만 확인하기 위해서 합성곱층의 필터/커널의 크기를 3X3으로 고정

- 역사적으로 VGGNet 이후로 네트워크의 깊이가 확 깊어짐

- 네트워크 계층의 총 개수에 따라 여러 유형의 VGGNet(VGG16, VGG19) 등이 있음

- VGGNet은 새로운 구조보다는 네트워크의 깊이가 끼치는 영향에 집중했기 때문에 단순히 3X3 합성곱층을 겹치는 구조를 만듦

- 위 이미지에서 3X3 필터로 두 번 합성곱을 하는 것과 5X5 필터로 한 번 합성곱을 하는 것이 결과적으로 동일한 사이즈의 특성맵을 산출

- 3X3 필터가 2개면 총 18개의 가중치를 갖는데 5X5필터는 25개의 가중치를 가지기 때문에 3X3필터를 사용하는 것이 훈련 속도가 빨라짐

- 동시에 층의 갯수가 늘어나면서 활성화함수를 한 번 더 사용하게 되어 특성의 비선형성이 증가되어 유용한 특성을 찾기 유리해짐

- 하지만 일정 깊이 이상에서는 성능 개선 효과가 미미함

728x90

'09_DL(Deep_Learning)' 카테고리의 다른 글

| 24_전이학습(transfer learning)_keras (0) | 2025.05.07 |

|---|---|

| 23_전이학습(transfer learning)_pytorch (0) | 2025.05.07 |

| 21_Fashion_MNIST(파이토치) (2) | 2025.05.02 |

| 20_파이토치_기초예제(car_evaluation) (3) | 2025.05.02 |

| 19_파이토치_기초문법 (0) | 2025.05.02 |